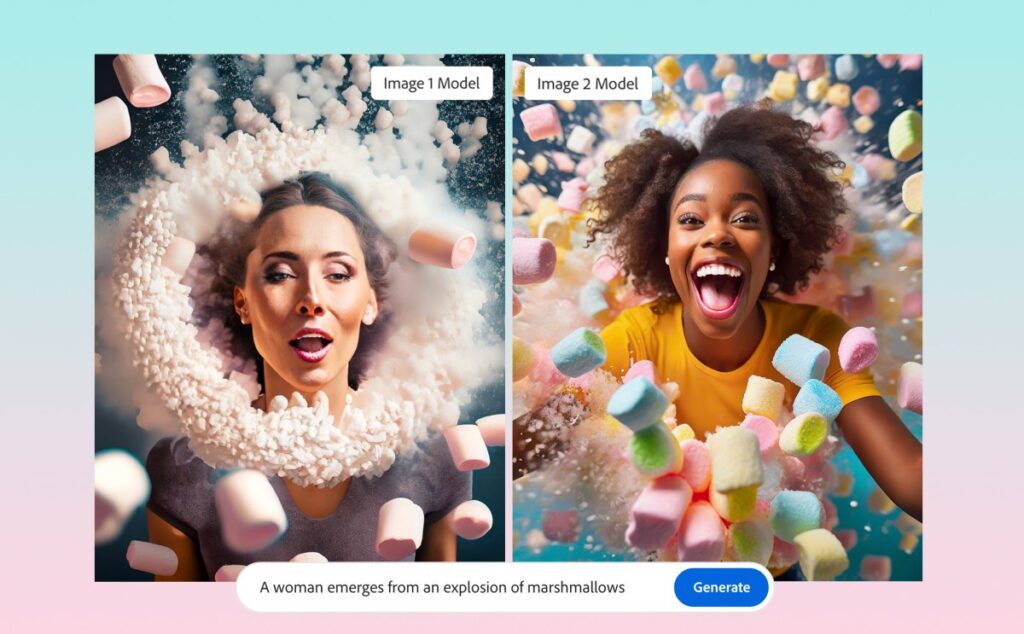

Lors de MAX, sa conférence annuelle pour les créatifs, Adobe a annoncé aujourd’hui qu’elle avait mis à jour les modèles qui alimentent Firefly, son service de création d’images par IA générative. Selon Adobe, le modèle Firefly Image 2, comme il est officiellement appelé, sera plus performant pour rendre les humains, par exemple, y compris les traits du visage, la peau, le corps et les mains (qui ont longtemps posé problème aux modèles similaires).

Adobe a également annoncé aujourd’hui que les utilisateurs de Firefly ont généré trois milliards d’images depuis le lancement du service il y a environ six mois, dont un milliard rien que le mois dernier. La grande majorité des utilisateurs de Firefly (90 %) sont également des nouveaux utilisateurs des produits Adobe. La majorité d’entre eux utilisent certainement l’application web Firefly, ce qui explique pourquoi, il y a quelques semaines, la société a décidé de transformer ce qui était essentiellement un site de démonstration pour Firefly en un service Creative Cloud à part entière.

Crédits image : Adobe

Alexandru Costin, vice-président d’Adobe chargé de l’IA générative et de Sensei, m’a expliqué que le nouveau modèle n’a pas seulement été entraîné sur des images plus récentes provenant d’Adobe Stock et d’autres sources commercialement sûres, mais qu’il est également beaucoup plus grand. « Firefly est un ensemble de modèles multiples et je pense que nous avons multiplié leur taille par trois », m’a-t-il dit. « C’est donc comme un cerveau trois fois plus grand, qui saura comment établir ces connexions et rendre de plus beaux pixels, de plus beaux détails pour l’utilisateur. L’entreprise a également multiplié l’ensemble des données par près de deux, ce qui devrait permettre au modèle de mieux comprendre les demandes des utilisateurs.

Ce modèle plus vaste est évidemment plus gourmand en ressources, mais M. Costin a indiqué qu’il devrait fonctionner à la même vitesse que le premier modèle. « Nous poursuivons nos explorations et nos investissements dans la distillation, l’élagage, l’optimisation et la quantification. Il y a beaucoup de travail pour s’assurer que les clients bénéficient d’une expérience similaire, mais nous ne pensons pas que le coût du cloud soit trop élevé ». Pour l’instant, Adobe privilégie la qualité à l’optimisation.

Pour l’instant, le nouveau modèle sera disponible via l’application web Firefly, mais il sera également disponible dans les applications Creative Cloud comme Photoshop, où il permet d’utiliser des fonctions populaires comme le remplissage génératif, dans un avenir proche. C’est également un point sur lequel Costin a insisté. La façon dont Adobe envisage l’IA générative n’est pas tant la création de contenu que l’édition générative, a-t-il déclaré.

« Ce que nous avons vu nos clients faire, et c’est la raison pour laquelle le remplissage génératif de Photoshop connaît un tel succès, ce n’est pas seulement générer de nouveaux actifs, mais prendre des actifs existants – une prise de vue, une prise de vue de produit – et ensuite utiliser des capacités génératives pour améliorer les flux de travail existants. C’est pourquoi nous appelons notre terme générique pour définir la générativité comme une édition plus générative que le simple texte-image, car nous pensons que c’est plus important pour nos clients ».

Avec ce nouveau modèle, Adobe introduit également quelques nouvelles commandes dans l’application web Firefly qui permettent désormais aux utilisateurs de définir la profondeur de champ de leurs images, ainsi que les paramètres de flou de mouvement et de champ de vision. Autre nouveauté, la possibilité de télécharger une image existante et de faire correspondre Firefly au style de cette image, ainsi qu’une nouvelle fonction d’auto-complétion pour l’écriture de vos messages (qui, selon Adobe, est optimisée pour vous aider à obtenir une meilleure image).